Inteligencia Artificial

-

Del laboratorio a tu escritorio: ejecutando inteligencia artificial fácilmente ...¡en tu equipo local!

Durante los últimos meses, y particularmente en las últimas semanas, la atención en diversas redes sociales se ha enfocado en noticias sobre inteligencia artificial generativa y en fenómenos virales como las reinterpretaciones artísticas de imágenes al estilo del famoso estudio japonés de animación Ghibli:

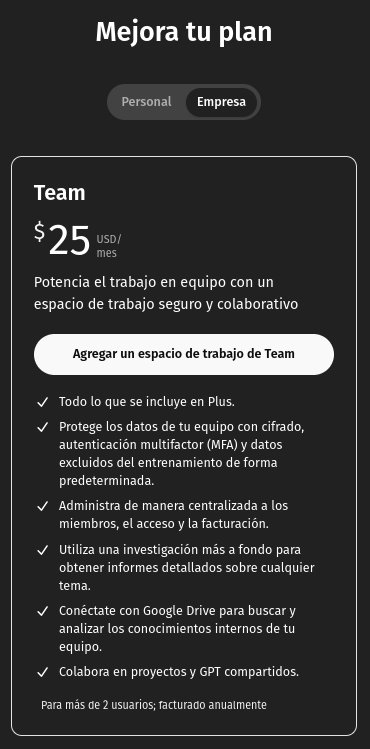

Estas tendencias demuestran las capacidades de los nuevos modelos de inteligencia artificial generativa y cómo cada avance desata una competencia frenética e interesante por ver quién desarrolla el modelo más capaz, más rápido o más avanzado. Sin embargo, algo en lo que generalmente no reparamos, o quizás subestimamos, es que gran parte de las funcionalidades más avanzadas suelen estar tras un muro de pago. ¿Qué alternativas tenemos si deseamos explorar este nuevo mundo desde nuestro computador de escritorio o portátil?

Primero, es importante saber que varios de estos modelos son de código abierto o derivan de modelos abiertos. Sin embargo, el hecho de que sean de código abierto no significa que sean fáciles de ejecutar. Muchos tienen un tamaño considerable, fácilmente superior a los 400 GB, y al ejecutarse podrían requerir más de 1 TB de VRAM (que es como se denomina a la memoria de las tarjetas gráficas GPUs). Generalmente, los computadores domésticos tienen un máximo de 8 GB de VRAM, haciendo casi imposible ejecutar modelos muy grandes, como el DeepSeek R1 de 671 mil millones de parámetros.

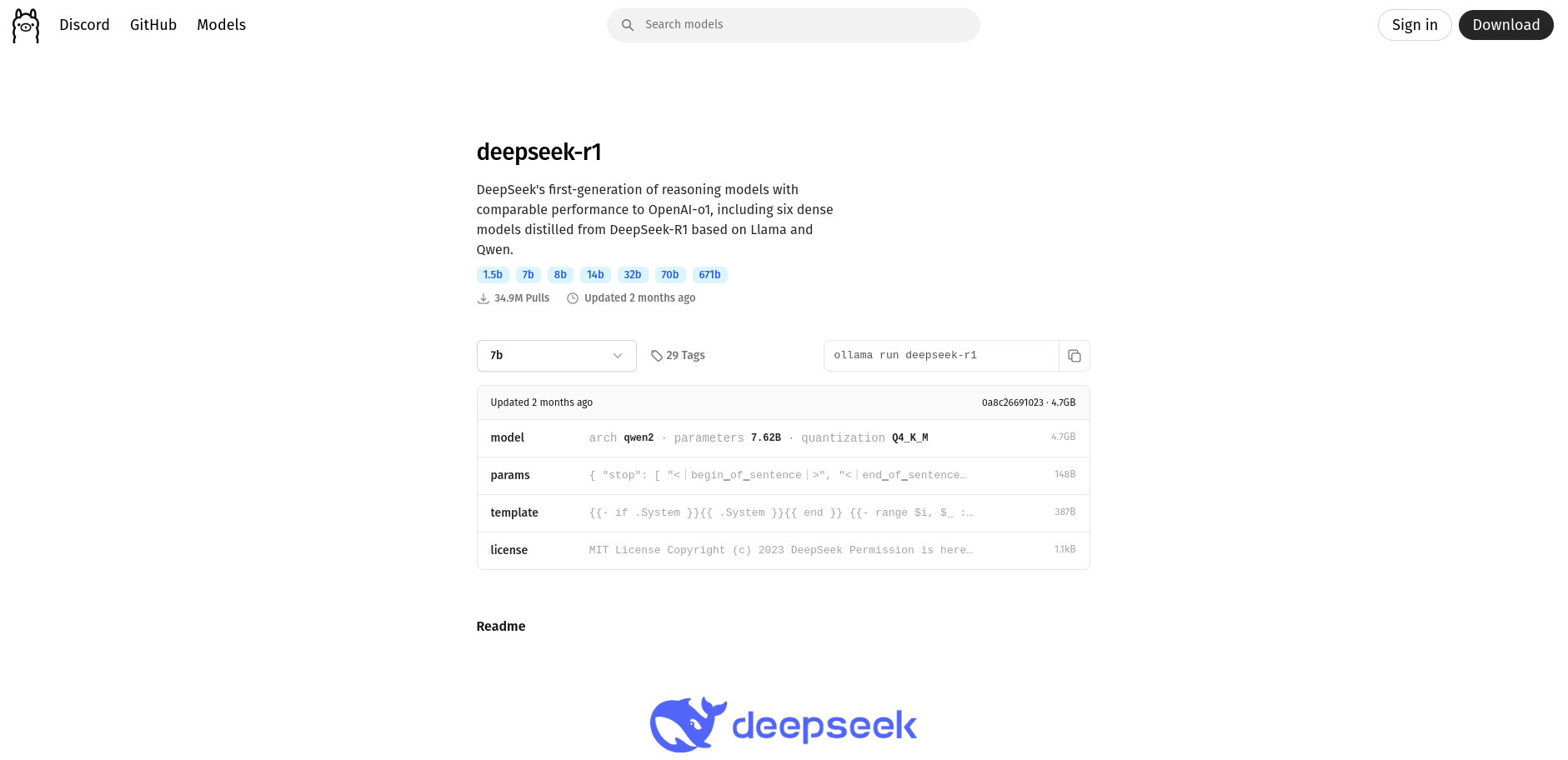

Primero, es importante saber que varios de estos modelos son de código abierto o derivan de modelos abiertos. Sin embargo, el hecho de que sean de código abierto no significa que sean fáciles de ejecutar. Muchos tienen un tamaño considerable, fácilmente superior a los 400 GB, y al ejecutarse podrían requerir más de 1 TB de VRAM (que es como se denomina a la memoria de las tarjetas gráficas GPUs). Generalmente, los computadores domésticos tienen un máximo de 8 GB de VRAM, haciendo casi imposible ejecutar modelos muy grandes, como el DeepSeek R1 de 671 mil millones de parámetros.Afortunadamente, no todo son malas noticias. Actualmente existen modelos derivados mucho más pequeños gracias a técnicas como la destilación o la cuantización. Estas técnicas optimizan los modelos, reduciendo su tamaño y requisitos computacionales, aunque con menor precisión y menos parámetros disponibles. Por ejemplo, un modelo como el DeepSeek R1 de 671 mil millones de parámetros y aproximadamente 400 GB puede reducirse a un derivado como el deepseek-r1:1.5b, de tan solo 1.78 mil millones de parámetros y 1.1 GB, permitiendo su ejecución en casi cualquier computador moderno.

Pero entrando en materia: ¿cómo ejecutar estos modelos en nuestro computador de escritorio? Si tienes Linux, puedes hacerlo fácilmente usando Ollama, una herramienta de código abierto para ejecutar modelos de lenguaje grandes (LLMs) localmente.

Para instalar Ollama, abre una terminal y ejecuta:

curl -fsSL https://ollama.com/install.sh | shEste comando descargará e instalará Ollama. Luego, ejecuta el siguiente comando para iniciar el modelo:

ollama run deepseek-r1:1.5bOllama descargará y ejecutará el modelo automáticamente. En la página oficial de Ollama (https://ollama.com/search) encontrarás otros modelos y sus comandos correspondientes.

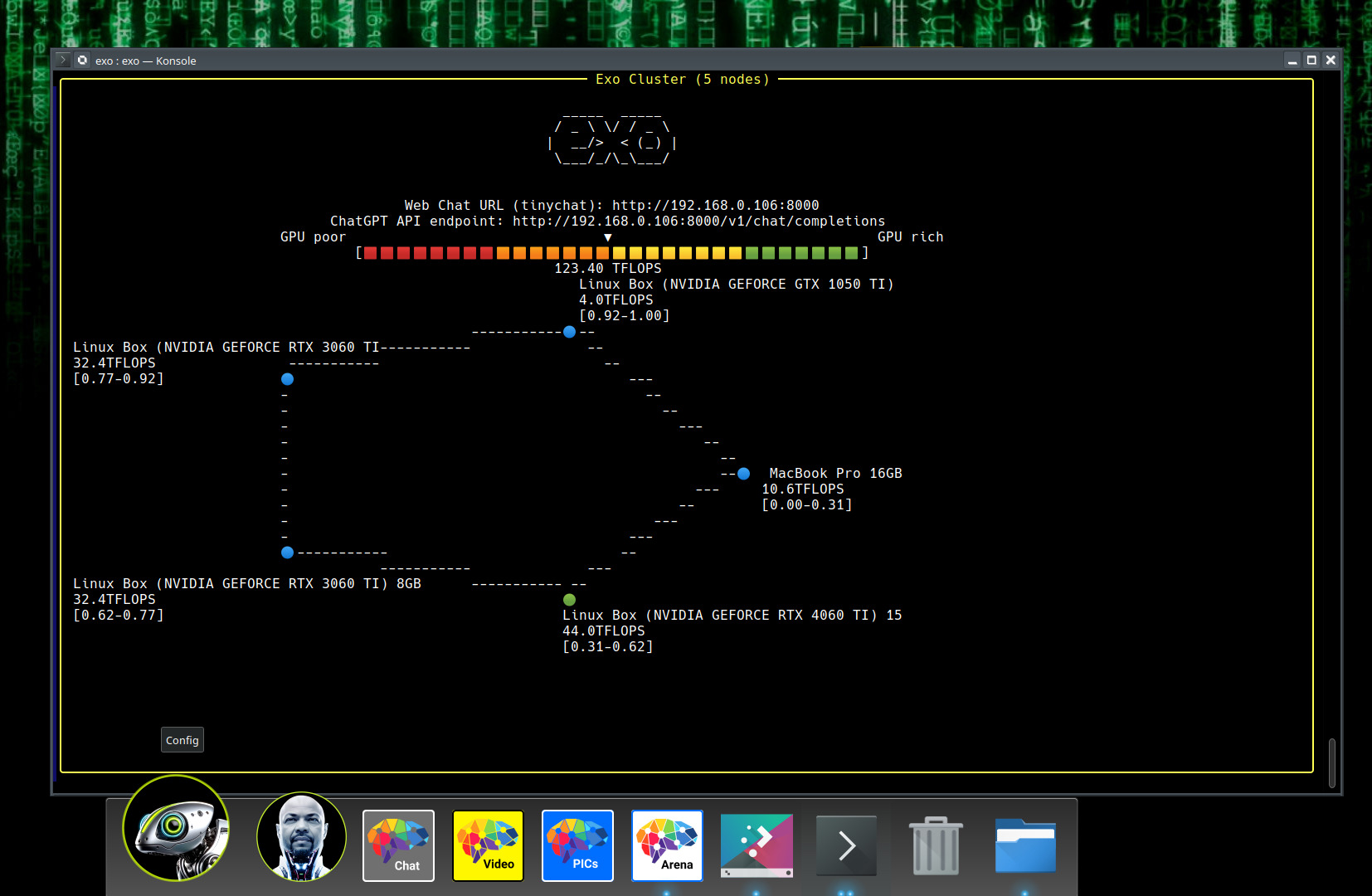

Ahora bien, quizás quieras usar un modelo más potente, como deepseek-r1:32b (32 mil millones de parámetros), que requiere mínimo 30 GB de VRAM. Aunque esto puede ser complicado o costoso, puedes utilizar la herramienta EXO de Exo Labs. Este software de código abierto permite crear un clúster de inteligencia artificial doméstico usando dispositivos cotidianos (PC, Mac, tablets, Raspberry Pi, etc.) conectados a la misma red, unificando sus capacidades de cómputo y VRAM mediante conexión P2P.

Para instalar EXO en Linux, ejecuta estos comandos en una terminal:

git clone https://github.com/exo-explore/exo.git cd exo pip install -e .Luego, ejecuta este comando en cada dispositivo conectado a la red:

exoAl hacerlo, EXO detectará automáticamente todos los dispositivos en la red, unificando sus recursos.

Luego podrás acceder a la interfaz web similar a ChatGPT visitando:

Allí, selecciona el modelo que desees utilizar y empieza a interactuar.

Finalmente, está el proyecto HART (Efficient Visual Generation with Hybrid Autoregressive Transformer), un modelo nuevo que genera imágenes en alta resolución (1024x1024), comparable en calidad con modelos avanzados de difusión. Usa una técnica novedosa llamada tokenizador híbrido, dividiendo la información de la imagen para mejorar calidad, velocidad y uso eficiente de recursos.

Para instalar HART en tu sistema, ejecuta estos comandos en una terminal:

git clone https://github.com/mit-han-lab/hart cd hart conda create -n hart python=3.10 conda activate hartInstala CUDA si tienes una tarjeta NVIDIA:

conda install -c nvidia cuda-toolkit -yLuego instala HART:

pip install -e . cd kernels && python setup.py installDescarga otros modelos necesarios para HART:

git clone https://huggingface.co/mit-han-lab/Qwen2-VL-1.5B-Instruct git clone https://huggingface.co/mit-han-lab/hart-0.7b-1024pxPara usar HART con interfaz gráfica:

python app.py --model_path /ruta/al/modelo --text_model_path /ruta/a/Qwen2Para generar imágenes desde la terminal:

python sample.py --model_path /ruta/al/modelo \ --text_model_path /ruta/a/Qwen2 \ --prompt "DESCRIPCIÓN DE LA IMAGEN" \ --sample_folder_dir /ruta/para/guardar/imagenes \ --shield_model_path /ruta/a/ShieldGemma2BEjemplo práctico:

python hart/sample.py --model_path hart-0.7b-1024px/llm \ --text_model_path Qwen2-VL-1.5B-Instruct \ --prompt "A little cat and dog playing in a sunny park with colorful flowers and a bright sky" \ --sample_folder_dir output_images --use_ema=FalseResultado:

Como puedes ver, hay diversas maneras de ejecutar potentes modelos de inteligencia artificial desde nuestros computadores locales, permitiéndonos explorar a fondo estas tecnologías sin costos adicionales.

Bonus Track:

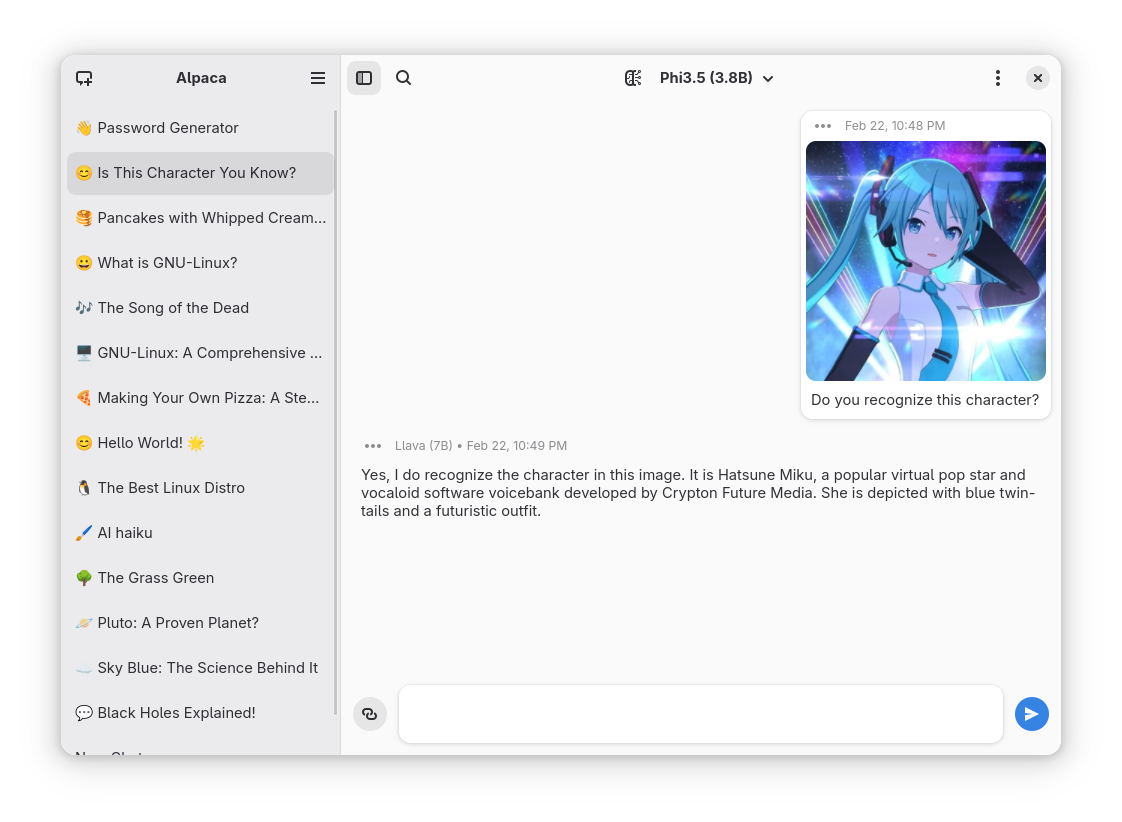

Otra forma simple de poder ejecutar LLMs de manera local es simplemente instalando Alpaca una aplicación de código abierto que permite interactuar con modelos de inteligencia artificial (IA) de forma privada y local en dispositivos Linux. Utiliza Ollama para gestionar y ejecutar modelos de IA directamente en el dispositivo del usuario, garantizando que todas las conversaciones y datos se almacenen localmente sin depender de servicios en la nube.

Entre sus principales características se incluyen:

- Interacción con múltiples modelos de IA en una misma conversación.

- Gestión de modelos, permitiendo descargar y eliminar modelos directamente desde la aplicación.

- Reconocimiento de imágenes (disponible con modelos compatibles).

- Procesamiento de documentos de texto plano y PDFs.

- Importación y exportación de chats.

- Incorporación de transcripciones de YouTube y contenido de sitios web en las conversaciones.

Alpaca está disponible para su instalación a través de Flathub ejecutando los siguientes comandos:

flatpak install flathub com.jeffser.Alpacaluego:

flatpak run com.jeffser.Alpaca-

Como ves, la inteligencia artificial ya no es exclusiva de grandes centros tecnológicos; ahora está al alcance de tu computador personal. Con herramientas sencillas y accesibles, explorar el fascinante mundo de los modelos generativos es más fácil que nunca.

¿Y tú, ya has probado alguno de estos modelos en casa? Cuéntanos tu experiencia o qué modelo te gustaría probar primero. ¡Anímate a descubrir el poder de la IA desde tu escritorio!

-

IA en Ciberseguridad ...sentido común al ataque

Es innegable que entramos en una nueva era, aunque sigue siendo pertinente la frase universal de cada ola tecnológica:

La Inteligencia Artificial es como la sexualidad entre adolescentes...hablan mucho de ella, presumen mucho de ella, piensan mucho en ella, ven el mundo a través de ella...pero realmente pocos saben cómo funciona y muchos menos la usan responsablemente.

Las promesas recurrentes...en este caso para ciberseguridad: mejoramiento de los estándares actuales de operación, disminución de costos, reducción de la necesidad de especialistas. Todo mediado con una urgente avalancha de ciberataques más sofisticados ¿pero, realmente ha cambiado en terminos generales el objetivo central: lograr una ciber-resiliencia que garantice la operación del negocio minimizando los costos al máximo?

Parafraseando a nuestro amigo Asimov en alguna de sus obras: toda tecnología que alcanza un nivel de sofisticación suficiente para escapar a la comprensión humana convencional, tiende a asimilarse a magia...

Un poco de contexto

Hipersimplificando... en el boom de infoxicación acerca de lnteligencia Artificial en el que navegamos, podemos decir que tenemos dos grandes artefactos tecnológicos:

- Deep Learning: básicamente es el entrenamiento sofisticado de redes neuronales gigantescas usando conjuntos de datos a escala planetaria, es un caso particular del Machine Learning

- AI Generativa: con una innovación derivada de las ciencias de la computación al más alto nivel...el Transformador (no tiene que ver con cine pero sí con la 'T' de ChatGPT), una red neuronal industrial entrenada, tiene por fin la capacidad de generar contextos y relaciones sofisticadas y en gran medida coherentes, para el conjunto de datos que le estamos entregando.

La aplicación inmediata la tuvimos en el NLP (procesamiento del lenguage natural)...y eureka! estos contextos y relaciones a simple vista para el ojo humano desinformado pueden ser inteligentes, superan la prueba de Turing y para el ojo entrenado nos acerca al sueño de tener un asistente robot como el que vimos en Interstellar.

A nivel histórico es el equivalente a la domesticación del fuego, la agricultura, la creación del motor de la era industrial o la bomba atómica...aquí arranca una nueva era, con la diferencia de que la retroalimentación de innovación es muchísimo más acelerada, hablamos de meses no de milenios ni siglos ...obviamente esto fué posible gracias al modelo Open Source y muchas matemáticas, al mejor estilo de Newton, parándose en hombros de gigantes.

Adopción de IA en cyberseguridad

Realmente la tasa de adopción de IA en el sector de cyberseguridad es alta, no es algo nuevo: +70% para soluciones tipo deeplearning y +60% para IA generativa, con más de un 20% de soluciones in-house, cifras en crecimiento. Hablamos de entornos industriales de nivel corporativo internacional (dejemos de lado empresas convencionales y más aún universidades en LATAM).

La aplicación de IA generativa es relativamente novedosa en el nicho, y su uso NO se orienta a acompañar las largas jornadas de soledad de expertos del sector, tiene entre otras, una función similar a la de una interfaz más humana en el pipeline de trabajo, ofreciendo resumenes inmediatos de actividades de ataque, posibles recomendaciones automatizadas, queries más efectivos sobre analíticas de registro, sin necesidad de depender estrictamente de programación engorrosa.

Mientras que en el uso de Deep Learning soportamos actividades repetitivas como identificación de url's maliciosas, detección de malware, con adaptación más rápida de lo que podría hacer un humano o un script de tamizaje vieja guardia, porque se tiene la capacidad de aprender. Estas actividades se soportan no tanto en modelos masivos como Copilot o Gemini, sino en modelos de menor escala pero mucho más especializados para nuestro nicho.

La IA es un complemento, pero realmente no puede, como lo ofrecen algunos vendedores, reemplazar la experticia humana, actualmente no dormiría tranquilo, si tuviera que delegar mi defensa frente a organizaciones criminales (que también están innovando a un ritmo acelerado), a una solución tercerizada, automatizada y generalmente de presupuesto abultado. En cambio, SI es una oportunidad, para disminuir el desgaste del talento humano especializado que soporta la operación, capacitar el personal de relevo (entre otras cosas), en una industria que sufre de escasez de seniors.

Debido al boom de IA en el sector tecnológico se han generado espectativas que no necesariamente corresponden a la realidad de su adopción en el sector de ciberseguridad, esto ha sido inpulsado, por una especie de campaña mediática nivel ejecutivo, el cuál no siempre se articula con la división de ingeniería.

Aparentemente se tiene la impresión de que la adopción de una solución de IA automágicamente garantiza por si sola la optimización de la operación de seguridad, con un aceleramiento del retorno sobre la inversión realizada en estas innovaciones, pero la aproximación requerida para la situación bien podría ser inversa: se requiere mejor, dar foco en la eliminación de los cuellos de botella de la operación, para disminuir el desgaste del equipo de seguridad, lo cuál únicamente puede hacerse mejorando procesos y adoptando tecnología de avanzada, lo que redundará en un ROI efectivo, resultados de impacto en negocio y tranquilidad. Es una espiral de operación que nace en la organización y se proyecta hacia su entorno externo (no a la inversa desde ingeniería comercial acelerada de catálogo), pivoteando en todo momento en los skills humanos in-house.

Riesgos

La última ventaja que realmente se está aprovechando desde las organizaciones y grupos criminales, es la capacidad que ofrece la IA Generativa para mejorar la credibilidad en sus engaños, principalmente ha sido un tema de contenidos de gran calidad que son fácilmente aceptables como verdaderos. Errores de ortografía, traducciones forzadas, información desactualizada, desaparecen con la ayuda de LLMs de uso público. Tecnologías como deepfake han sorprendendido con las capacidades de suplantación que ofrecen. Sin embargo, el objetivo de los ataques sigue siendo el tradicional: el aprovechamiento del factor humano, eso no ha cambiado. El entrenamiento in-house para una organización criminal, de un motor especializado es costoso, continua siendo más efectivo el uso de actores humanos bien entrenados apoyados en LLMs públicos.

No hay nada más peligroso que un falso sentido de seguridad. La adopción de una solución de IA sobre la que no hay auditoría en la calidad de los datos con los que ha sido entrenada, es un salto al vacío (garbage in, garbage out). Y si por temas de presupuesto o eficiencia, no se tiene un personal que la respalde, con experiencia comprobada de nicho, sumado a despliegues tecnológicos de baja calidad...de nuevo, sentido común, sólo tenemos humo y espejos.

Cómo mencionábamos anteriormente, todo parte desde la organización. Ella es quien debe identificar el ámbito particular de aplicación, para luego identificar y desarrollar el modelo de despliegue más adecuado. Una adopción iterativa de soluciones de GenAI permite disminuir las dudas sobre el ROI real de un aplicativo de IA. Todavía no está claro cómo se va a medir este retorno, ¿cuántas horas efectivas de trabajo se liberarán realmente en nuestro equipo? ¿qué otro parámetro de impacto en el TCO de ciberseguridad puede medirse?, nos encontramos en pleno hype comercial.

Responsabilidad Humana

Sorprende la habilidad de la IA para simular capacidades coginitivas humanas, para encontrar patrones, su potencialidad para reemplazar actividades repetitivas o que involucran altos volúmenes de datos, sin embargo, su novedad parece hacernos olvidar, que la responsabilidad de la operación, siempre ha sido y será, en última instancia humana. La IA te avisará que el sistema está en riesgo, si fué bien desplegada y si tu equipo tiene la capacidad de sacarle provecho, pero eso es tu problema...de nuevo, sentido común.

Elementos prácticos

Si la aproximación de la ciber-delincuencia arranca desde contenidos engañosos más sofisticados, tiene sentido potenciar esas áreas: detección automática de correos de phishing generados por IA, detección de tonos y estilos de redacción sospechosos.

Y para temas de suplantación, códigos de confirmación a nivel humano (no necesariamente digitial), llamadas de confirmación (esto para mitigar la clonación de voz)...interesante que estrategias muy de los años 80's coloquen en jaque un intento sofisticado de clonación como estos.

Resumiendo, la IA es sólo otra herramienta más en el toolkit de defensa, ¿es un game changer? ¡absolutamente! pero es tecnología al final de la jornada.

Continua siendo estratégico, liberar al equipo de seguridad de tareas operativas para que puedan realmente aportar a la operación del negocio, disminuir fatiga, desarrollar capacidades, entrenar nuevo personal.

Lecturas introductorias interesantes

- AI Research (Sophos)

- Cybersecurity (Sophos)

- News (Sophos)

- Defensive AI

- Bringing AI to Cloudflare

- SASE (Cloudflare)

- Artificial intelligence (AI) vs. machine learning (ML)

- What Is Deep Learning?

- What’s the Difference Between Deep Learning and Neural Networks?

Imagenes Originales de sus autores (Attribution in alt description). Esta creación ha sido inspirada en parte en lecturas de trabajo de distintas fuentes (Sophos, Cloudflare, Otros)